Nat. Hum. Behav. 速递:语义投影从词嵌入中还原丰富的语境知识 |

您所在的位置:网站首页 › 投影 temp › Nat. Hum. Behav. 速递:语义投影从词嵌入中还原丰富的语境知识 |

Nat. Hum. Behav. 速递:语义投影从词嵌入中还原丰富的语境知识

|

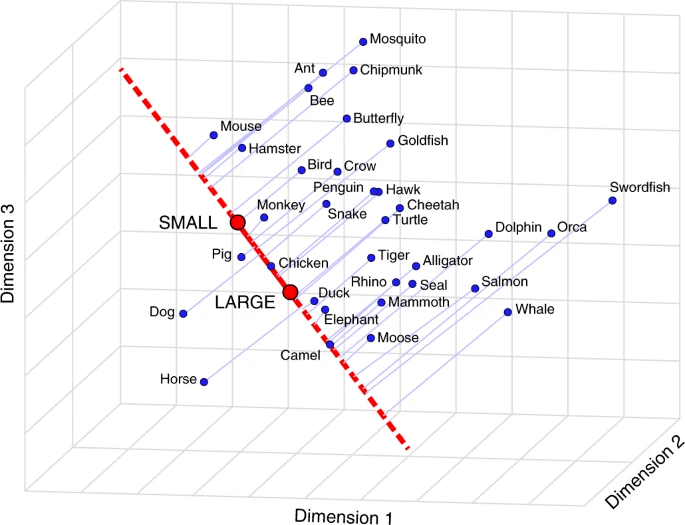

论文题目:Semantic projection recovers rich human knowledge of multiple object features from word embeddings 论文链接:https://www.nature.com/articles/s41562-022-01316-8 1. 语义投影作为特征标尺 一组词向量能够蕴含丰富的语境信息。如果两个词语在空间上的位置更加接近,则能够说明他们在整个语料中更倾向于出现在类似的语境当中。但是有一个问题,当我们在说两个词语相似的时候,我们实际上在说什么?由于现实世界事物的丰富性,一个对象难免会有多个维度的不同特征。例如,海豚与短吻鳄在体型上相近,但是危险性却大有不同。本文作者创新性地设计了一个称之为 语义投影(semantic projection)的方法,从词向量中挖掘多个维度的信息。 图1中穿过小(SMALL)和大(LARGE)两个词的红线代表了一把标尺。蓝点所代表的动物越靠近SMALL一侧,则更可能具有小的体型;更靠近LARGE一侧,则反之。可以看到SMALL一侧有比较多的诸如蚁(Ant)、鼠(Mouse)、蜜蜂(Bee)等动物;而LARGE一侧则有鲸鱼(Whale)、象(Elephant)等动物——这说明语义投影的方法能够比较好地捕捉到人类世界知识中这些动物的大小关系。

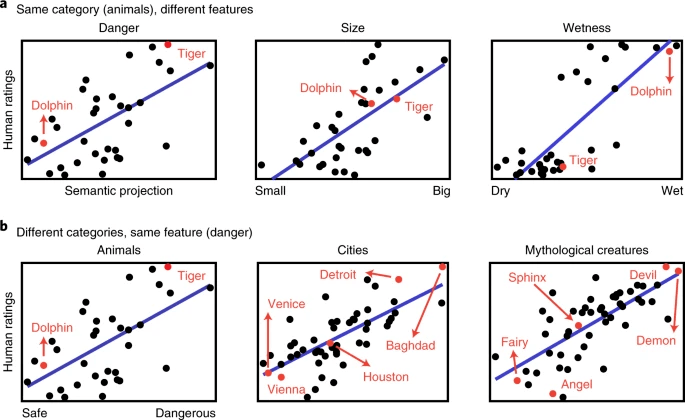

图1. 用PCA降维至3D的词向量(源于GloVe方法生成的300D词向量)所展示语义投影方法,以动物类别的尺寸特征为例。红点为一对特征词(SMALL和LARGE),相连成红线即为特征标尺;蓝点为不同的动物,引到红线上的淡蓝线为正交投影线。 2. 语义投影还原多样世界知识 进一步的研究发现,语义投影方法能够在特征或者类别发生变动时,较好预测人类关于某些特征的判断。见图2a红点标出的海豚(Dolphin)与虎(Tiger)这两种动物,直觉告诉我们:虎远远比海豚危险,但它们大小相似,而海豚因生活在水中而有更高的湿度——这与语义投影的预测相符。图2b与图2a类似,但是发生变化的是类别,这里不再赘述。图中其他散点也显示, 从词向量中还原出的知识与人类判断是正相关的。

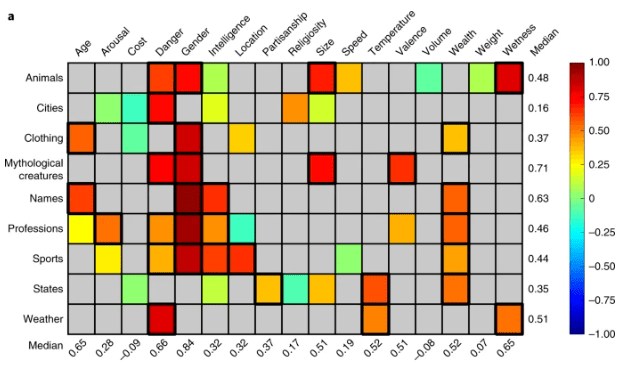

图2. 语义投影预测人类判断的案例,每个组合均有25个参与者提供人类评分。a 固定类别(动物),变动特征(危险性、尺寸、湿度);b 变动类别(动物城市,文物,神话生物),固定特征(危险性)。 研究者随后在更广泛的类别与特征组合上展示了结果的有效性。图3展示了「9种类别」x「17种特征」组合的预测情况。以第七列位置(Location,标尺为indoors-outdoors,即室内-户外)为例,运动(Sports)与位置显著相关(室内、户外运动),而职业(Professions)与位置的关联相对更弱,这大体符合人类关于位置的知识;而对于最后一行天气(Weather)来说,危险(Danger)与否和温度(Temperature)、湿度(Wetness)确实都是人类关心的,均有显著关联。读者可以尝试自行验证其它的组合,其中大部分的组合均能较好符合人类直觉。

图3. 语义投影预测多种类别与特征上的人类评分效果。图中颜色对应Pearson相关性(灰色是未做实验的组合),行、列分别代表类别与特征,行、列的中位数分别在最后一列与最后一行标出。统计显著的拟合结果格子被粗框围绕。 3. 还原丰富词向量信息的新方法 语义投影方法的使用证明, 词向量中实际上确实明确地编码了比我们原先想象更加丰富的语境知识,目前我们从其中挖掘到的信息可能只触及其表面,因此后续可以基于此思路开发更优的模型、挖掘更多的信息。 另外,除了有优异的还原效果,与先前从自然语言使用模式中提取语义知识的尝试相比,这种方法需要的人工监督和/或语料库注释要少得多,因此从应用上来说,该方法有望为各种语料灵活地恢复各种语义特征,甚至能够把不同学科的语料转换为知识含量丰富、更加易用的数据。 论文 Abstract How is knowledge about word meaning represented in the mental lexicon? Current computational models infer word meanings from lexical co-occurrence patterns. They learn to represent words as vectors in a multidimensional space, wherein words that are used in more similar linguistic contexts—that is, are more semantically related—are located closer together. However, whereas inter-word proximity captures only overall relatedness, human judgements are highly context dependent. For example, dolphins and alligators are similar in size but differ in dangerousness. Here, we use a domain-general method to extract context-dependent relationships from word embeddings: ‘semantic projection’ of word-vectors onto lines that represent features such as size (the line connecting the words ‘small’ and ‘big’) or danger (‘safe’ to ‘dangerous’), analogous to ‘mental scales’. This method recovers human judgements across various object categories and properties. Thus, the geometry of word embeddings explicitly represents a wealth of context-dependent world knowledge. 复杂科学最新论文 研究速递:从百万词汇语料库挖掘性别差异,原来People = Man? 从推理走向感觉:PNAS研究揭示社交媒体时代的集体语言理性衰落 预训练语言模型如何学习事实性知识?兼论一种因果干预的评估方法 《张江·复杂科学前沿27讲》完整上线! 成为集智VIP,解锁全站课程/读书会 加入集智,一起复杂! 研究速递:从百万词汇语料库挖掘性别差异,原来People = Man? 从推理走向感觉:PNAS研究揭示社交媒体时代的集体语言理性衰落 预训练语言模型如何学习事实性知识?兼论一种因果干预的评估方法 《张江·复杂科学前沿27讲》完整上线! 成为集智VIP,解锁全站课程/读书会 加入集智,一起复杂! 返回搜狐,查看更多 |

【本文地址】

今日新闻 |

推荐新闻 |